Un récent article de Vice raconte l’histoire des correcteurs automatiques, une histoire qui « a commencé chez Microsoft au début des années 90 ». L’auteur conclut par ces mots :

Aussi perfectionnés soient-ils, les derniers systèmes de correction et de suggestion ne connaissent pas le sens des mots – seulement leur orthographe et les relations qui les unissent. Ancrer une compréhension sémantique de la plus simple des langues dans la cervelle figée d’une machine est encore impossible.

Un jour, peut-être, les ordinateurs maîtriseront mieux les règles du langage que les êtres humains eux-mêmes. Reste qu’ils ne pourront jamais prédire vos intentions avec précision : aussi augmentée et surveillée soit-elle, votre écriture sera toujours la vôtre. Les petites entreprises de correction automatique le savent bien. […]

« Les correcteurs automatiques ne seront[-ils] jamais bons », comme le titre l’article ? Je l’ignore. Le traitement automatique du langage était déjà avancé quand j’étais étudiant, au milieu des années 1980. Les traducteurs automatiques et les logiciels de correction tels qu’Antidote ou ProLexis en sont le résultat (les dictionnaires actuels en bénéficient aussi, à travers l’analyse de corpus). Aujourd’hui, ces logiciels progressent sur le plan sémantique, terrain de l’intelligence humaine.

Dès 2000, un professeur de français, Xavier Bihan, après avoir testé ProLexis, écrivait : « […] si la correction n’est pas parfaite à 100 %, le résultat est amplement satisfaisant1. » Je crains que ce ne soit aussi l’avis de bien des éditeurs. Si la marge d’erreur est acceptable, ils se passeront de nous, correcteurs. Beaucoup le font déjà. En effet, comme l’écrivait Que choisir en 2012 : « Même dans les collections les plus prestigieuses, il est aujourd’hui impossible d’ouvrir un livre sans rencontrer, au détour d’un paragraphe, une coquille ou une faute de grammaire. Et le pire est à venir2. »

M. Bihan ajoutait :

Si les correcteurs qui nous sont actuellement proposés sur le marché sont désormais très performants sur le plan de la vérification lexicale, grammaticale et syntaxique, ils ne sont pas encore arrivés au bout de leur développement et les recherches portent actuellement sur la vérification sémantique et stylistique. Le correcteur sémantique se chargeant de veiller à ce que les mots ne produisent pas de contradiction ou d’absurdité alors que le correcteur stylistique traitera la chaîne de caractères que forme la phrase pour repérer les répétitions, les phrases trop longues, les anglicismes, les pléonasmes, les mots vulgaires.

« […] la compréhension de la signification sémantique des mots d’une phrase reste une tâche en cours de recherche », confirme un autre article vingt ans plus tard3.

Un spécialiste du traitement automatique du langage naturel (TALN), François Yvon, en a expliqué les difficultés en janvier 2007 :

Une des limitations de pratiquement tous les systèmes de traitement un peu sophistiqués est qu’ils font appel à une somme importante de connaissances d’expert : lexiques, règles de grammaire, réseaux sémantiques… Ceci explique en partie pourquoi il n’existe pas de système de traitement qui soit à la fois complet (i.e. intégrant tous les niveaux de traitement) et indépendant du domaine (i.e. capable de traiter avec une même efficacité n’importe quel type de texte). Il existe une autre raison, moins visible, qui limite l’avancée des progrès en TALN, et qui est que, pour un bon nombre de phénomènes, l’état de la connaissance linguistique est insuffisament formalisée pour pouvoir être utilisée par les concepteurs de systèmes de TALN4

Mais les années passent et les progrès sont manifestes. « Tout ce qui peut être automatisé le sera », entend-on souvent dire de nos jours.

En janvier 2018, des modèles d’intelligence artificielle développés par Microsoft et Alibaba réussissent chacun de leur côté à battre les humains dans un test de lecture et de compréhension de l’université Stanford. Le traitement automatique du langage naturel imite la compréhension humaine des mots et des phrases et permet maintenant aux modèles d’apprentissage automatique de traiter de grandes quantités d’informations avant de fournir des réponses précises aux questions qui leur sont posées5.

Au début de l’année dernière, un article du CNRS annonce :

Le traitement automatique du langage naturel a été chamboulé en [novembre] 2018 par la publication de BERT, un modèle de langue proposé par Google. « Avant, chaque mot était manipulé sous forme d’un vecteur unique, explique Laurent Besacier, professeur à l’université Grenoble Alpes. Des modèles comme Word2vec décrivaient de façon unique des mots pourtant polysémiques, comme “avocat”. »

À l’inverse, BERT adapte sa représentation vectorielle des mots en fonction du contexte et fait ainsi la différence selon que l’on parle d’un fruit ou d’un juriste. C’est d’ailleurs ainsi qu’il s’entraîne : le modèle prend une phrase et masque un ou plusieurs mots au hasard, qu’il tente ensuite de deviner. Ce principe le rend extrêmement performant, mais BERT a besoin d’être modifié pour chaque langue autre que l’anglais.

Des chercheurs du Laboratoire d’informatique de Grenoble (LIG, CNRS/Univ. Grenoble Alpes), du Laboratoire d’analyse et modélisation de systèmes pour l’aide à la décision (LAMSADE, CNRS/Université Paris Dauphine-PSL) et du Laboratoire de linguistique formelle (LLF, CNRS/Université Paris Diderot) ont donc développé FlauBERT, une version française de BERT.

Ils l’ont entraîné à partir d’un corpus de 71 gigaoctets de textes dans la langue de Molière, composés de tout Wikipédia en français, de plusieurs années du journal Le Monde, des ouvrages francophones du projet Gutenberg (dont bien entendu du Flaubert) ou encore des transcriptions des débats du Parlement européen6 .

C’est plus qu’un grand lecteur ne lira jamais.

En juin dernier, le société française Synapse Développement annonce une nouvelle version de Cordial, son correcteur orthographique, « boosté[e] à l’intelligence articielle » :

Cordial Néo promet une qualité de correction encore jamais vue grâce à l’intelligence artificielle. Fruit de 25 ans de recherche en traitement automatique du langage, la technologie de correction de Cordial Néo permet une véritable analyse sémantique et assure une correction optimale de vos textes avec un taux de correction record de 90 % pour la grammaire et de plus de 99,5 % pour l’orthographe7.

« Nous avons fait un choix éditorial », explique Kevin Comte, le responsable communication du logiciel français, dans l’article de Vice cité au début du présent billet. Quand quelque chose pose un doute, nous le soulignons et nous proposons des explications à l’utilisateur. Il lui appartient de corriger s’il en a envie. »

Pour l’instant, le rédacteur et le correcteur professionnel gardent la main sur la machine. Jusqu’à quand ?

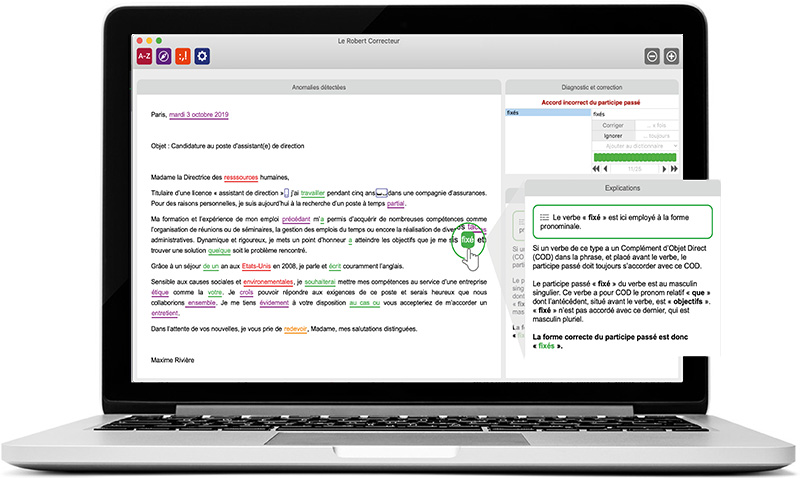

Source photo : Le Robert Correcteur.

- Xavier Bihan, Les correcteurs, Linguapolis, Humboldt-Universität zu Berlin, 2000. [Consulté le 7 mars 2021.]

- À qui la faute ? (PDF), Que choisir, janvier 2012.

- NLP – Natural Language Processing : introduction, DataScientest, 22 juillet 2020. [Consulté le 7 mars 2021.]

- François Yvon, Une petite introduction au traitement automatique des langues naturelles (PDF), janvier 2007. [Consulté le 7 mars 2021.]

- Traitement automatique des langues – Wikipédia. [Consulté le 7 mars 2021.]

- FlauBERT à la rescousse du traitement automatique du français, CNRS, 16 janvier 2020. [Consulté le 7 mars 2021.]

- Cordial Néo, le correcteur orthographique boosté à l’intelligence artificielle, Informatique News, 29 juin 2020. [Consulté le 7 mars 2021.]